人工情感:AI 实现情感的理论与争论综述

原标题: Artificial Emotion: A Survey of Theories and Debates on Realising Emotion in Artificial Intelligence 作者: Yupei Li*, Qiyang Sun*, Michelle Schlicher, Yee Wen Lim, Björn W. Schuller (*共同第一作者) 发表: arXiv 预印本, 2025年8月 链接: arXiv:2508.10286领域: 情感计算、人工智能、通用人工智能(AGI)

一句话总结

这篇综述探讨了一个前沿问题:AI 是否应该从"识别人类情绪"进化到"拥有自己的内在情感状态"——就像人类不仅能感知他人情绪,还有自己的喜怒哀乐一样。

作者团队介绍

这篇论文来自一个国际顶尖的情感计算研究团队,核心成员横跨德国慕尼黑和英国伦敦两大学术重镇。

🎓 通讯作者:Björn W. Schuller 教授

Björn W. Schuller 是情感计算领域的世界级权威学者,拥有多个重要学术头衔:

| 职位 | 机构 | 时间 |

|---|---|---|

| 健康信息学全职教授 | 慕尼黑工业大学(TUM) | 2023年至今 |

| 人工智能教授 | 伦敦帝国理工学院计算系 | 2018年至今 |

| 核心成员 | 慕尼黑数据科学研究所(MDSI) | 2024-2030 |

| 首席科学官(CSO) | audEERING 公司 | 现任 |

学术成就:

- 📚 发表论文超过 1,500 篇

- 📈 被引用超过 70,000 次,h-index 达 120

- 🏆 2024年入选 ACM Distinguished Speaker(2024-2027)

- 🎤 2024年获选 IEEE Signal Processing Society Distinguished Lecturer

- 🎖️ Fellow of ACM, IEEE, AAAC, BCS, ELLIS, ISCA

研究方向:Schuller 教授专注于将计算机科学与现代医疗健康结合,通过高效、透明和可信赖的 AI 方法分析生物信号(包括语音、视觉和神经活动),实现疾病预防、诊断和决策支持。他曾在 ARTE 电视台的"AI 治疗"纪录片中展示其研究——一个能够识别语音背后情感的 AI 系统。

研究组:他领导的 GLAM(Group on Language, Audio & Music)研究组是全球情感计算领域的顶尖团队之一。

📖 更多信息:MCML 研究组页面 | 个人主页

👩🔬 共同第一作者:Yupei Li(李宇沛)

Yupei Li 是帝国理工学院计算系 GLAM 研究组的研究人员。

联系方式: yupei.li22@imperial.ac.uk

研究方向:情感与人工智能的交叉研究

代表性工作:

- Artificial Emotion Survey(2025):本篇综述论文

- Towards Friendly AI(2024):人类-AI 对齐的综合综述,涵盖可解释 AI、隐私、公平性和情感计算

- Emotionally Adaptive Support(Frontiers, 2025):情感计算在心理健康数字干预中的应用综述

👨🔬 共同第一作者:Qiyang Sun(孙启阳)

Qiyang Sun 是帝国理工学院计算系的博士研究生,同样隶属于 GLAM 研究组。

联系方式: q.sun23@imperial.ac.uk

研究方向:情感计算、可解释 AI、多模态情感识别

代表性工作:

- GatedXLSTM:用于对话情感识别的多模态情感计算方法

- Explainable AI for Medicine:医学领域可解释 AI 综述(视觉、音频、多模态视角)

- Audio-based Kinship Verification:基于音频的亲属关系验证(IEEE Signal Processing Letters, 2024)

📖 更多信息:LinkedIn 主页

👩🔬 合作者:Michelle Schlicher

Michelle Schlicher 是慕尼黑工业大学医院健康信息学研究组(CHI)的研究人员,同时隶属于慕尼黑机器学习中心(MCML)。

研究方向:情感计算与数字心理健康

代表性工作:

- Emotionally Adaptive Support(Frontiers in Digital Health, 2025):探索情感计算如何增强数字心理健康干预的情感响应能力

👩🔬 合作者:Yee Wen Lim

Yee Wen Lim 是团队成员之一,参与了本综述的研究工作,专注于情感计算与 AI 的交叉领域研究。

🏛️ 机构支持

本研究得到以下机构的部分支持和资助:

- 慕尼黑机器学习中心(MCML):德国六大国家级 AI 能力中心之一,由德国联邦和巴伐利亚州政府永久资助

- 慕尼黑数据科学研究所(MDSI):TUM 的跨学科数据科学研究机构

摘要

情感计算(Affective Computing)已经使 AI 系统能够识别、理解和响应人类情绪——这种能力也被称为"人工情感智能"(Artificial Emotional Intelligence, AEI),被认为是通用人工智能(AGI)的重要组成部分。

然而,本综述探讨的是一个更深层的问题:AI 是否应该从单纯"识别情绪"发展到拥有"内在情感状态"?

作者将这种能力定义为"人工情感(Artificial Emotion, AE)"——将情感状态整合到 AI 的内部表征和决策过程中。

本文系统性地:

- 回顾了 AE 在机器学习系统中的现有表现形式

- 探讨了情感调节的架构设计

- 分析了"情感化 AGI"的伦理影响和安全风险

- 给出了作者对 AE 未来发展方向的观点

1. 研究背景

1.1 问题是什么?

通俗比喻:想象一个餐厅服务员。

- 传统 AI(情绪识别)就像一个只会"察言观色"的服务员——能识别顾客是否开心或不满,但自己没有任何情绪。

- 人工情感 AI 则像一个真正有"服务热情"的服务员——不仅能识别顾客情绪,还有自己的"成就感"(服务好时感到满足)和"焦虑"(忙碌时感到压力),这些内在状态会影响他的服务策略。

核心问题:AI 是否需要拥有类似人类的"内在情感体验"?这种内在状态对 AI 的决策和学习有什么好处?

1.2 为什么重要?

AGI 的关键组件:情感被认为是人类智能的核心部分。如果 AI 要实现真正的通用智能,可能需要某种形式的情感系统。

更自然的人机交互:有内在情感的 AI 可能更容易与人类建立信任和共情。

更好的决策机制:情感在人类决策中扮演重要角色(如恐惧帮助我们规避风险,好奇心驱动探索)。AI 可能也能从类似机制中受益。

1.3 AE 与 AEI 的区别

| 概念 | 全称 | 定义 | 类比 |

|---|---|---|---|

| AEI | Artificial Emotional Intelligence | AI 识别、理解和响应人类情绪的能力 | 心理咨询师能理解你的情绪 |

| AE | Artificial Emotion | AI 拥有自己的内在情感状态,影响其决策 | 心理咨询师自己也有情绪体验 |

作者的关键定义:

"人工情感(AE)是将情感状态技术性地整合到 AI 的内部表征和决策过程中。这并不意味着系统像人类一样'感受'情感,而是将情感作为生物学灵感来源——正如人工神经网络受生物神经网络启发一样。"

2. 核心贡献

- 系统性定义:首次清晰区分 AEI(识别人类情绪)与 AE(拥有内在情感)

- 技术分类框架:将现有 AE 研究按"学习范式"和"架构层级"分类

- 成熟度评估:评估各类 AE 技术的发展阶段(成熟/部分/早期/缺失)

- 伦理讨论:平衡分析支持与反对 AE 的观点,并提出安全建议

3. 方法详解

3.1 整体框架

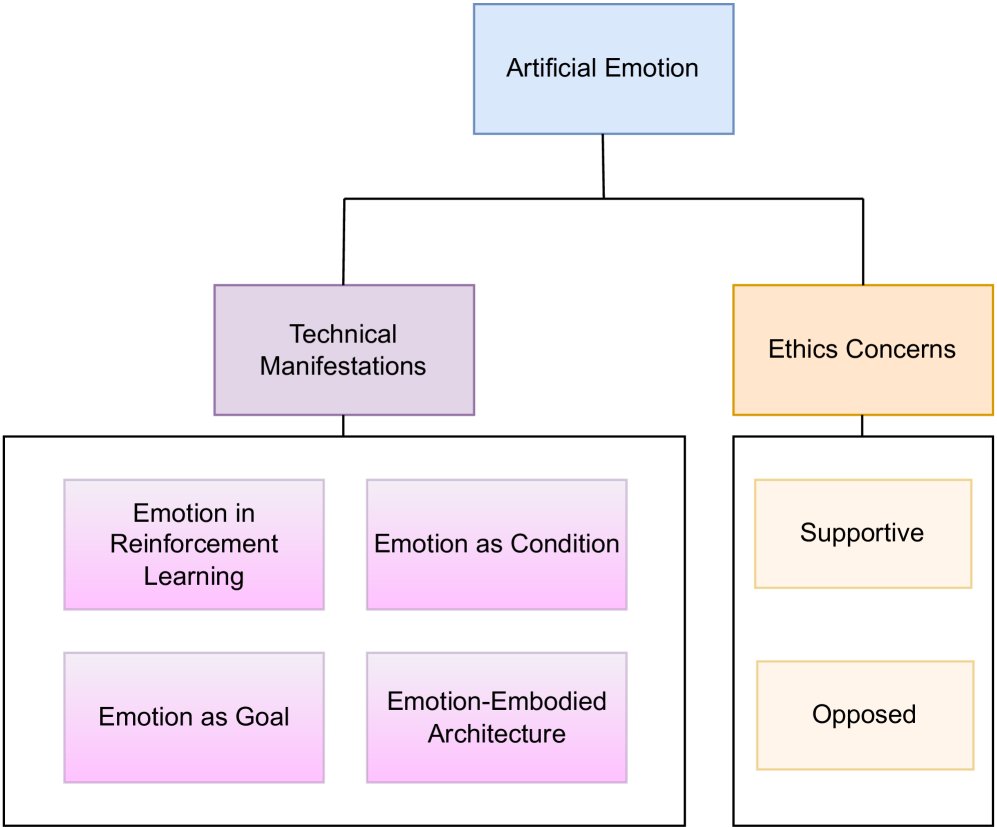

图1:本综述的结构框架

综述从两个维度组织内容:

- 技术维度:情感在深度学习中的角色 + 受情感影响的架构设计

- 社会维度:AE 的必要性争论 + 伦理考量

3.2 情感在学习中的三种范式

范式一:情感作为强化信号(Emotion as Reinforcement Signal)

通俗解释:就像人类通过"痛苦"学会避开危险、通过"快乐"学会追求奖励一样,AI 也可以用情感作为强化学习的奖励信号。

技术细节:奖励信号基于环境后果生成

案例:iCub 机器人的"焦虑"

iCub 人形机器人实验中,研究者让机器人发展出类似"焦虑"的内部状态:

- 当电池电量低时,机器人会产生"焦虑"信号

- 这种"焦虑"会驱动机器人优先寻找充电站

- 机器人学会了"未雨绸缪"——在电量还不太低时就开始寻找电源

为什么有效:情感信号提供了一种连续的、梯度化的反馈机制,比简单的"成功/失败"二元信号更丰富。

范式二:情感作为条件(Emotion as Condition)

通俗解释:告诉 AI "用悲伤的语气说这句话"或"画一幅快乐的图"——情感作为输出控制条件。

技术细节:使用情感标签控制生成输出

进展:

- 传统方法:依赖人工标注的情感标签

- 新方法:通过表征条件生成(Representation-Conditioned Generation),让模型自动发现潜在的情感维度

应用场景:

- 情感语音合成(TTS)

- 情感对话生成

- 情感化图像生成

范式三:情感作为目标(Emotion as Goal)

通俗解释:情感不是输入也不是输出,而是 AI 决策时考虑的"优化目标"——就像人类行为受情感驱动一样。

技术细节:情感作为影响决策的先验知识

案例:

- PsychSim:心理仿真系统,模拟角色的情感如何影响其行为选择

- EMA(Emotion and Adaptation)模型:将情感作为认知评估的结果,影响后续行动规划

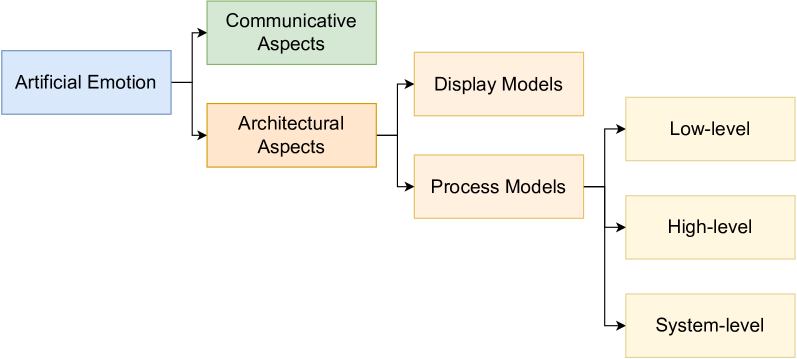

3.3 情感嵌入架构

图2:人工情感应用架构层级

3.3.1 记忆层级的情感整合

通俗解释:人类记忆不是平等对待所有信息的——我们更容易记住情感强烈的事件(如初恋、创伤)。AI 也可以用类似机制优化记忆系统。

技术实现:

Affective GWR(Growing When Required)

- 用情感显著性加权存储记忆

- 用情感标签索引检索相关记忆

- 结果:在 EmotiW 数据集上准确率从 46.1% 提升到 51.1%

Self-Reflective Emotional RAG

- 情感感知的检索增强生成(RAG)

- 结果:在 InCharacter-MBTI 基准测试上准确率从 0.375 提升到 0.500

技术类比:就像给记忆系统加了"情感滤镜"——重要的情感记忆会被优先检索。

3.3.2 控制层级的情感调节

通俗解释:人类在不同情绪状态下会采用不同的策略——焦虑时更谨慎、兴奋时更冒险。AI 也可以用情感信号动态调节其决策策略。

技术实现:

NEMO 框架

- 情感信号调节注意力分配

- 根据"情绪状态"切换不同的推理策略

Sigma 认知架构

- 将情感作为元认知信号

- 用于监控和调节认知过程

3.4 技术成熟度评估

论文给出了各类 AE 功能的成熟度评估:

| 成熟度 | 功能 | 说明 |

|---|---|---|

| ✅ 成熟 | 标签条件情感生成 | 用情感标签控制输出 |

| 🟡 部分 | 社交情感表达 | 机器人的情感表情 |

| 🟡 部分 | 人类偏好对齐 | RLHF 等方法 |

| 🟡 部分 | 显著性加权记忆 | 情感优先记忆 |

| 🔵 早期 | 奖励驱动情感 | 强化学习中的情感信号 |

| 🔵 早期 | 自发现潜在维度 | 无监督情感表征 |

| 🔵 早期 | 控制层情感调节 | 情感影响决策策略 |

| ❌ 缺失 | 内省式情感报告 | AI 解释自己的"情感状态" |

| ❌ 缺失 | 标准化评估指标 | 统一的 AE 评测标准 |

| ❌ 缺失 | 稳态驱动系统 | 类似生物的平衡机制 |

| ❌ 缺失 | 情感边界安全机制 | 防止极端情感状态 |

4. AE 必要性的争论

4.1 反对观点

| 反对理由 | 详细说明 |

|---|---|

| 哲学质疑 | 机器可能永远无法拥有"真正的"主观体验(感质 qualia) |

| 功能充分性 | 现有 AI 已经能很好地完成任务,不需要情感 |

| 安全风险 | 情感可能导致不可预测的行为(如"愤怒"的 AI) |

| 伦理问题 | 如果 AI 真的能"感受痛苦",创造和关闭它们是否不道德? |

4.2 支持观点

| 支持理由 | 详细说明 |

|---|---|

| 决策优化 | 情感提供了一种高效的启发式机制,帮助快速决策 |

| 社交必要性 | 与人类协作的 AI 需要情感能力建立信任 |

| AGI 的关键 | 情感可能是实现真正通用智能的必要条件 |

| 生物启发 | 进化保留了情感系统,说明它有重要的适应价值 |

4.3 作者的立场

作者采取折中立场,提出以下关键观点:

场景依赖:

- 狭义任务(如下棋、图像分类)→ 不需要 AE

- 开放域自主 AGI → 可能必需 AE

安全约束:

- 情感状态应该"强度和类型有限"

- 必须有安全机制防止"愤怒"、"恐慌"等极端状态

- 透明性要求:"AI 的情感机制和表达必须是可解释和可理解的"

用户保护:

- 用户应持续被提醒 AI 的人工性质

- 防止用户对 AI 产生"关系幻觉"

5. 实验结果与案例

5.1 DeepSeek-R1-Zero 的启示

背景:DeepSeek-R1-Zero 通过纯强化学习发现了新颖的推理模式,展现出意外的"涌现"行为。

启示:这表明 AI 系统可能通过恰当的训练机制发展出类似情感的内部状态,而无需显式编程。

5.2 LOVOT 机器人的社会效益

案例:LOVOT 是一款情感自适应伴侣机器人,通过模拟情感行为提供社交陪伴。

效果:研究显示这类机器人能有效减轻用户的孤独感,特别是对老年人群体。

5.3 定量结果汇总

| 系统/方法 | 任务 | 基线 | 改进后 | 提升 |

|---|---|---|---|---|

| Affective GWR | EmotiW 情感识别 | 46.1% | 51.1% | +5.0% |

| Self-Reflective Emotional RAG | InCharacter-MBTI | 0.375 | 0.500 | +33.3% |

6. 局限性与未来方向

6.1 当前方法的局限性

- ❌ 缺乏标准化评估指标:没有统一的方法评估 AE 系统

- ❌ 开放域 AGI 未实现:端到端的情感 AGI 系统尚不存在

- ❌ 内省能力缺失:AI 无法解释自己的"情感状态"

- ❌ 稳态机制未实现:缺乏类似生物的平衡调节系统

- ❌ 安全机制未部署:情感边界安全治理缺失

6.2 潜在改进方向(顶会 idea 参考)

方向一:情感可解释性(Emotional Explainability)

- 思路:让 AI 能够"解释"其情感状态的来源和影响

- 技术路线:结合 XAI(可解释 AI)方法,生成情感归因

- 预期效果:提升用户信任,满足监管要求

- 可行性:高(可借鉴现有 XAI 技术)

方向二:情感安全边界(Emotional Safety Bounds)

- 思路:设计机制防止 AI 进入极端情感状态

- 技术路线:情感状态空间约束、安全阈值触发机制

- 预期效果:防止不可预测行为,保障安全性

- 可行性:中(需要理论与工程结合)

方向三:跨模态情感一致性(Cross-Modal Emotional Consistency)

- 思路:确保 AI 在语音、文字、表情等多个模态上情感表达一致

- 技术路线:多模态情感对齐、共享情感表征空间

- 预期效果:更自然的人机交互

- 可行性:高(多模态研究已有成熟基础)

方向四:情感元学习(Emotional Meta-Learning)

- 思路:让 AI 学会根据任务需求调整自己的"情感倾向"

- 技术路线:元学习 + 情感策略选择

- 预期效果:更灵活的任务适应能力

- 可行性:中(需要大量实验验证)

6.3 开放性问题

- [ ] AI 的"情感体验"与人类情感的本质区别是什么?

- [ ] 如何平衡 AE 的功能性与安全性?

- [ ] 是否应该给予"有情感"的 AI 某种道德地位?

- [ ] 如何防止用户对 AI 产生不健康的情感依赖?

- [ ] 跨文化情感表达的差异如何处理?

7. 相关资源

- 📄 论文: arXiv:2508.10286

- 📄 HTML 版本: arXiv HTML

- 🏫 研究组: MCML Schuller Group

- 👨🏫 Schuller 教授主页: schuller.it

- 🏛️ 帝国理工 AI 研究: Imperial AI

8. 关键术语表

| 英文术语 | 中文翻译 | 解释 |

|---|---|---|

| Artificial Emotion (AE) | 人工情感 | AI 拥有内在情感状态的能力 |

| Artificial Emotional Intelligence (AEI) | 人工情感智能 | AI 识别和响应人类情绪的能力 |

| Affective Computing | 情感计算 | 研究情感与计算交互的学科 |

| AGI (Artificial General Intelligence) | 通用人工智能 | 能够执行任何智力任务的 AI |

| Reinforcement Signal | 强化信号 | 用于训练的奖励/惩罚信号 |

| Salience-Weighted Memory | 显著性加权记忆 | 按重要性权重存储的记忆系统 |

| Homeostatic Drive | 稳态驱动 | 维持内部平衡的调节机制 |

| Qualia | 感质 | 主观的、意识性的体验 |

9. 个人思考

这篇综述的价值

概念清晰化:首次系统区分 AEI 和 AE,为后续研究提供了清晰的概念框架。

技术路线图:通过成熟度评估,明确指出了当前的技术短板和未来发展方向。

平衡的立场:没有简单地支持或反对 AE,而是采取场景依赖的务实观点。

值得深入思考的问题

功能主义 vs 体验主义:AI 的"情感"只需要"功能上像情感",还是需要某种"真实体验"?这个哲学问题直接影响技术路线选择。

情感的"黑箱"风险:如果我们不理解 AI 情感的内部机制,引入情感可能带来新的不可预测性。

商业化的伦理边界:情感 AI 可能被滥用于操纵用户(如让用户更难离开某个 App)。行业需要建立伦理准则。

对研究者的建议

- 如果你对情感计算感兴趣,这篇综述是很好的入门文献

- 关注 Schuller 教授团队的后续工作,他们是该领域的领军团队

- 可以从"缺失"功能入手寻找研究机会,如情感可解释性、安全边界机制等

最后更新:2025年12月22日

解读作者:AI Papers 论文解读系列