15.2 ServiceNow:用 LangSmith 洞察客户成功代理

来源:How ServiceNow uses LangSmith to get visibility into its customer success agents

公司简介

ServiceNow 是领先的数字工作流平台,帮助企业在 IT、客户服务等部门转变服务管理。该公司的 AI 团队正在利用 LangSmith 和 LangGraph 开发智能多代理系统,编排整个客户旅程。

面临的挑战

ServiceNow 面临的核心问题是 代理系统碎片化:

- 多个部门的代理缺乏统一的协调层

- 难以处理跨越整个客户生命周期的复杂工作流

- 需要一个综合框架来评估工具完成度、准确性和路径优化

客户旅程覆盖阶段

ServiceNow 的 AI 代理系统覆盖完整的客户生命周期:

潜在客户资格认证

↓

机会发现(交叉销售/向上销售)

↓

经济采购方识别

↓

入职与实施

↓

采用跟踪

↓

使用与价值实现

↓

续约与扩展

↓

客户满意度与倡导技术架构

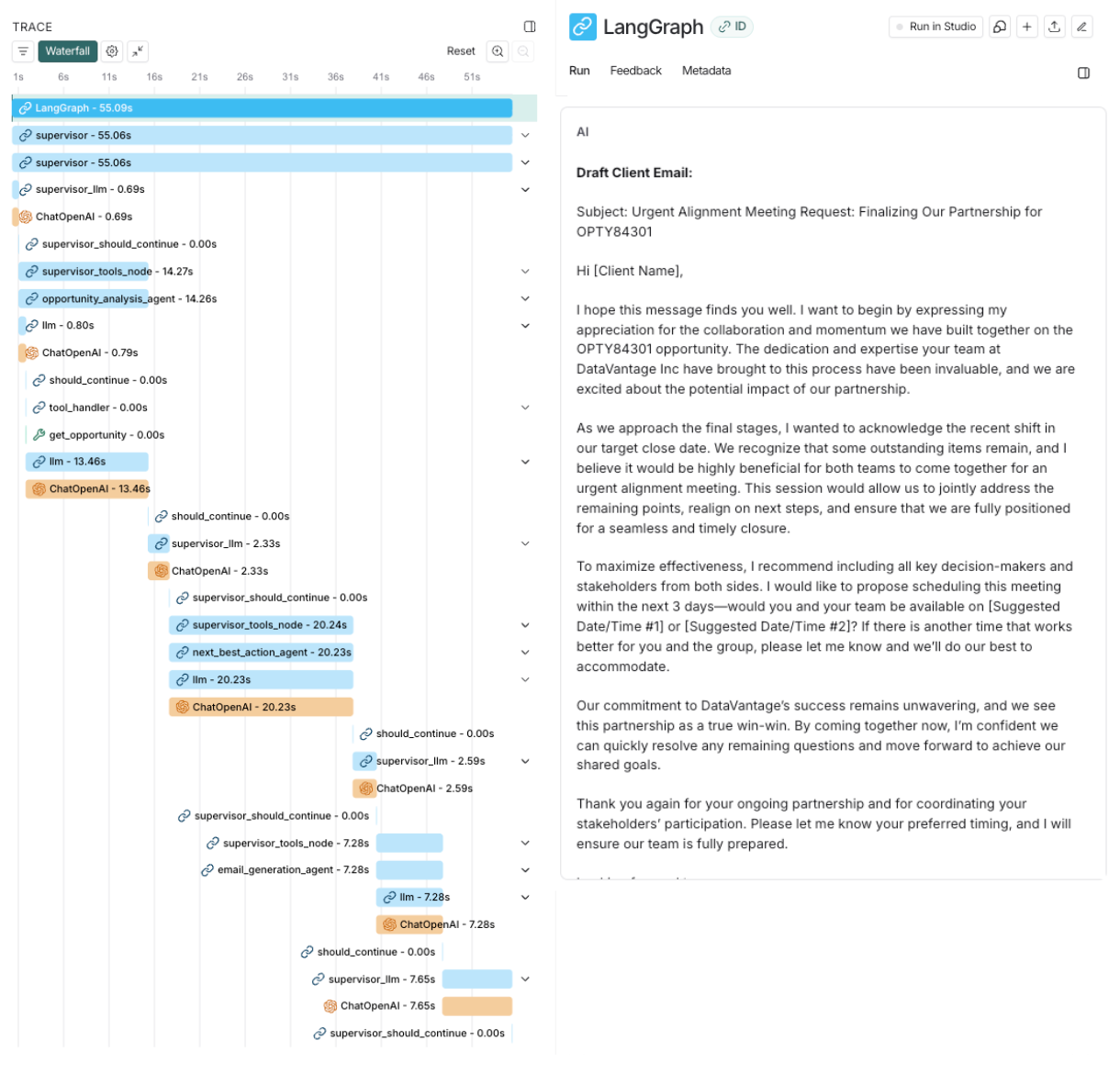

LangGraph 应用

ServiceNow 采用 监督代理(Supervisor Agent) 进行编排:

- 多个专门的子代理处理特定任务

- 广泛使用 map-reduce 风格的图

- 通过 Send API 和子图调用实现模块化

技术栈整合

| 组件 | 技术 |

|---|---|

| 编排框架 | LangGraph |

| 可观测性 | LangSmith |

| 知识管理 | Knowledge Graph |

| 上下文协议 | Model Context Protocol (MCP) |

LangSmith 使用方式

逐步调试

追踪代理决策过程的每一步:

潜在客户资格系统的邮件起草示例

观察数据流

在每个阶段观察输入/输出:

"observing input/output at every stage"

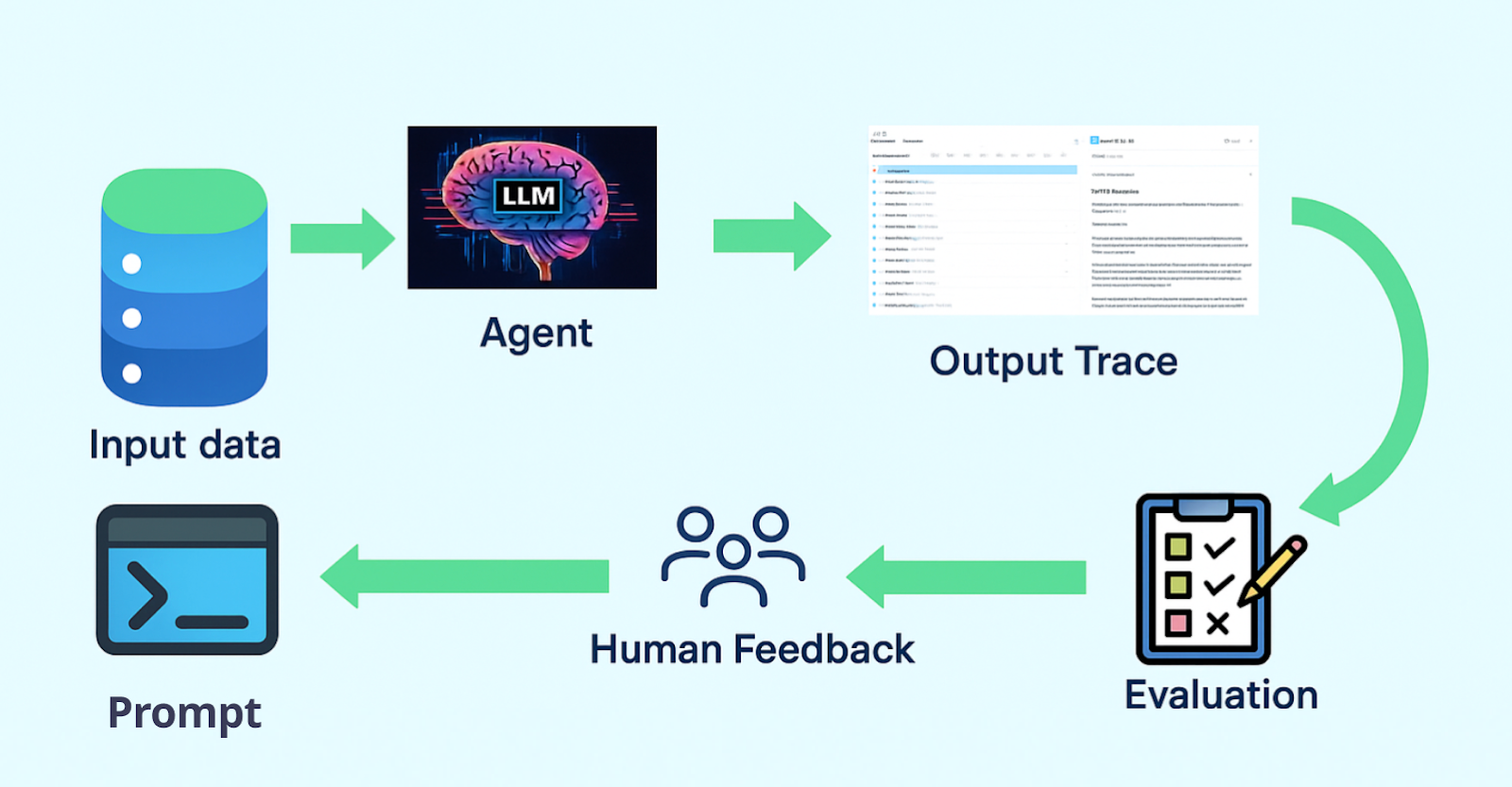

构建数据集

从追踪到评估的生命周期

从成功运行中创建黄金数据集,用于:

- 回归测试

- 性能基准

- 持续改进

Human-in-the-Loop 能力

ServiceNow 的人类在环能力显著提升了开发效率:

| 功能 | 说明 |

|---|---|

| 暂停执行 | 在关键节点暂停代理执行 |

| 批准/回滚 | 审核并决定是否继续 |

| 重启步骤 | 使用不同输入重新执行特定步骤 |

效果:大幅减少开发摩擦(dramatically reduced development friction)

评估框架

自定义计分器

针对每个代理的特定任务定制指标:

# 示例:自定义评估指标

- 工具调用准确率

- 响应完整性

- 路径效率

- 客户意图识别准确度LLM-as-a-Judge 评估器

使用 LLM 作为评判者评估代理输出质量

自动化质量保证

- 自动黄金数据集创建:从成功运行中提取

- 人类反馈集成:收集并整合人工评审

- 回归防止机制:确保更新不会降低性能

关键洞察

为什么选择 LangSmith?

"LangSmith offers detailed tracing capabilities...helps users to improve the agents performance"

"The intuitive structuring of trace data...makes debugging significantly easier"

架构设计亮点

- 模块化子图设计:每个业务阶段对应专门的子代理

- 统一编排层:Supervisor Agent 协调所有子代理

- 完整可观测性:从追踪到评估的闭环

- 持续优化循环:黄金数据集 → 评估 → 改进

总结

ServiceNow 的案例展示了如何在企业级场景中使用 LangGraph 和 LangSmith:

- 复杂工作流编排:覆盖完整客户生命周期

- 模块化架构:Supervisor + 多个专化子代理

- 深度可观测性:LangSmith 提供全链路追踪

- 持续改进机制:评估框架 + 人类反馈

这个案例为构建企业级多代理系统提供了宝贵的参考。

上一篇:[15.1 Jimdo](./15.1 Jimdo.md)

下一篇:[15.3 Monte Carlo](./15.3 Monte Carlo.md)